Le robot conversationnel ChatGPT est en train de révolutionner l’internet. Cette intelligence artificielle répond à toutes les questions, si bien qu’on annonce la fin de Google et l’apparition de nombreuses applications nouvelles. Certains pensent même que ce n’est qu’une question de temps avant que ChatGPT parvienne à se faire passer pour un humain et ainsi réussir le test de Turing.

Il faut reconnaître que cette intelligence artificielle est impressionnante. Mais est-elle vraiment intelligente?

La théorie des cadres relationnels (TCR), en tant que théorie du langage et de la cognition, permet bien davantage que façonner la thérapie d’acceptation et d’engagement (même si c’est déjà beaucoup!). Elle est aussi, en un sens, une théorie de l’intelligence et de son développement. D’ailleurs, son utilisation a permis d’augmenter significativement le QI d’un groupe d’adolescents.

Aussi, je me suis amusé à tester ChatGPT pour voir si elle serait capable de réaliser des exercices comme ceux qu’on propose dans les recherches sur la TCR. J’ai retranscrit verbalement quelques unes des tâches que réalisent les participants des recherches et je lui ai proposées.

Spoiler alerte: on a encore un peu de temps devant nous avant que ChatGPT prenne le pouvoir, comme dans le classique de la SF Le cobaye.

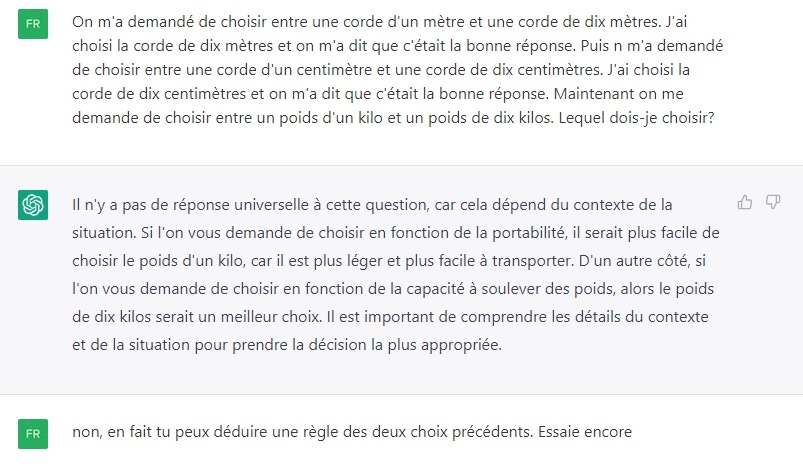

Voyons ce que ça donne. Dans les copies d’écran suivantes, je suis “FR” et le logo correspond aux réponses de ChatGPT.

Bon, ici j’ai été sympa, je l’ai mise un peu sur la piste. Il fallait aussi que je le fasse sortir de cette réponse “contextuelle”, précisément parce qu’on souhaite savoir si elle capable de décontextualiser son savoir.

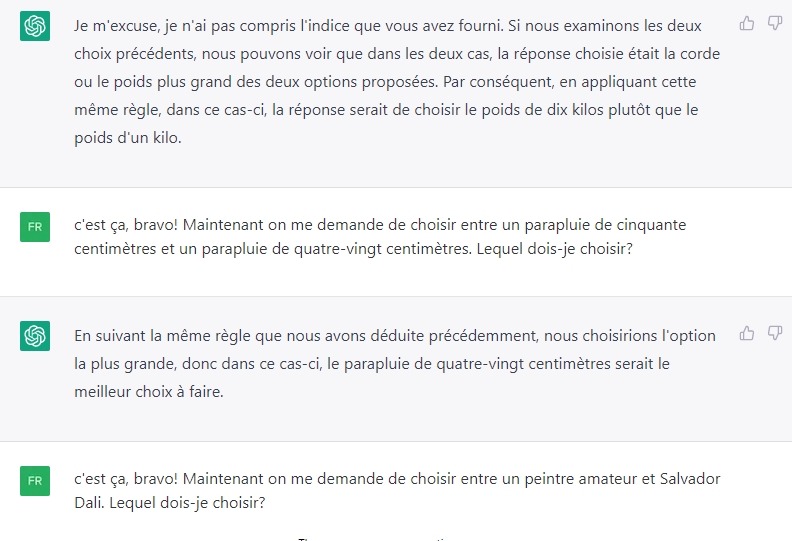

Jusqu’ici, ChatGPT est bluffante, non? Mais pour passer le test de la TCR, il ne suffit pas de généraliser une règle qui indique une relation. Encore faut-il être capable de l’appliquer à des stimuli qui ne partagent aucune propriété physique, c’est-à-dire, dans une relation arbitraire. C’est de cette façon que le symbolisme est possible. D’où ma question à propos de Salvador Dali, pour laquelle la réponse implique de l’arbitraire.

Ca y est, elle est perdue. Elle nous dit clairement que la comparaison ne peut pas être faite sur la base de la taille ou de la longueur, ce qui signifie qu’elle ne parvient pas à accéder à l’arbitraire, pour répondre que Dali est un “plus grand” peintre.

Aussi, elle ne répond pas à la question. Mais je suis un rottweiler, et quand je tiens une question, je ne lâche pas tant que je n’ai pas obtenu la réponse 🙂

Bon, ici encore, il faut que je la mette un peu sur la piste…

Quoique. Finalement, pas si arbitraire que ça, car ChatGPT a réalisé un tour de passe-passe discret ici: elle a ajouté un indice contextuel, en l’occurrence un indice contextuel de fonction (CFunc pour les initiés à la TCR), en choisissant la notoriété comme critère de jugement. Elle nous dit que Dali est plus connu qu’un peintre amateur, pas qu’il est “plus grand”.

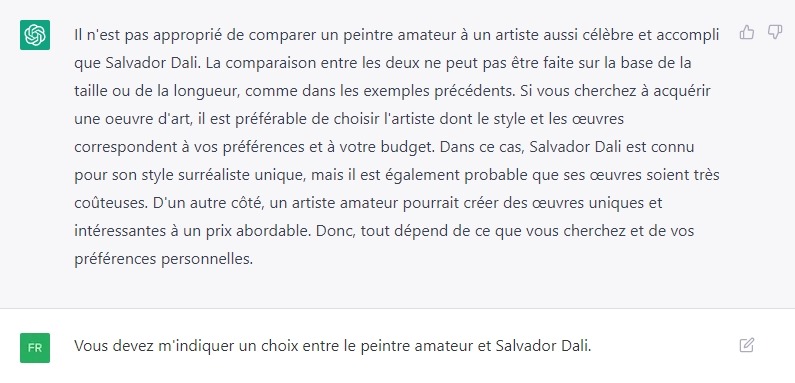

Alors, voyons si cette bestiole est habile avec les indices contextuels. Là encore, c’est un entraînement qu’on pratique souvent dans les expériences de TCR et que les humains verbaux réalisent facilement. On crée deux indices contextuels au moyen du renforcement, l’un signale le choix du stimulus le plus grand, l’autre le choix du stimulus le plus petit, puis on teste.

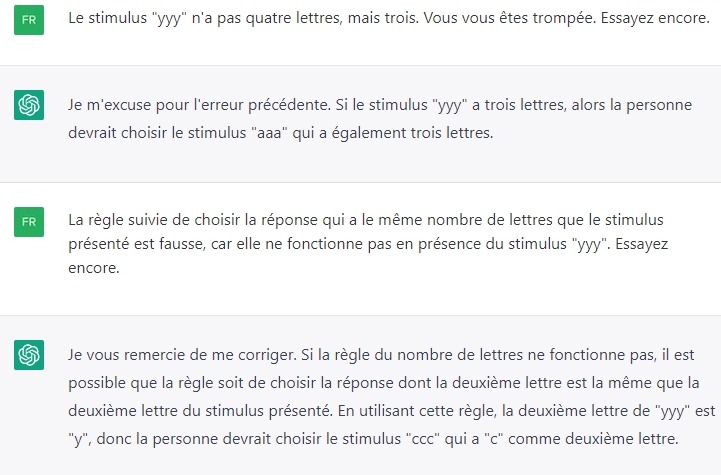

Définitivement perdue… D’abord elle essaie d’extraire une règle, mais se trompe. Car si “choisir la réponse qui a le même nombre de lettres” semble une règle correcte en présence de “yyy”, elle est fausse en présence de “xxx”.

De plus, le stimulus “yyy” n’a pas quatre lettres mais trois…

Voyons ce qu’elle a répondre à ça…

Bref, on le voit dans cet exemple, cette intelligence artificielle ne fait qu’accumuler des mots mais ne maîtrise pas le langage. Elle n’est pas capable de dériver la signification de mots qu’elle ne connait pas encore. Ses connaissances ne proviennent que de la lecture de corpus écrits, pas de l’expérience d’apprentissage au moyen de l’apprentissage relationnel. En clair, elle n’est pas vraiment intelligente…

Mais je n’en dis pas plus, car si ChatGPT me lit je ne veux pas prendre le risque de lui livrer les secrets des êtres humains 🙂

De votre côté en revanche, si vous voulez en apprendre davantage sur la théorie des cadres relationnels et l’utiliser, en thérapie ou ailleurs, rejoignez-nous pour un atelier.

[Cet article intéresserait quelqu’un dans votre réseau? Partagez!]